Introduction :

Le réchauffement climatique est de plus en plus alarmant et d’après les scientifiques, nous sommes la dernière génération à pouvoir inverser cette tendance. Les émissions de CO2 sont trop importantes et entraînent la planète vers un réchauffement désastreux de +3°C. Cependant, il est encore possible d’inverser la tendance en transformant radicalement l’économie et en plafonnant ces émissions. Pour ce faire, il est important que chacun prenne conscience de son impact sur l’environnement, que l’on soit un professionnel ou un particulier.

Dans ce projet « Virtual House », nous avons souhaité limiter notre étude aux particuliers, afin que nos propositions soient les plus adaptées possibles, que les prises de conscience soient les plus importantes et que les changements soient effectifs. Notre objectif est donc de sensibiliser chaque particulier sur son comportement vis-à-vis de sa consommation d’énergie et du changement climatique actuel. Ainsi, nous nous sommes focalisés sur l’utilisation des équipements électroménagers et de leur impact, afin de montrer à l’utilisateur qu’il est possible de réduire son impact sur l’environnement par des gestes simples. Notre projet cherche à répondre à la problématique sous la forme d’une prise de conscience interactive et ludique, tout en restant instructif afin de permettre d’apprendre à mieux consommer.

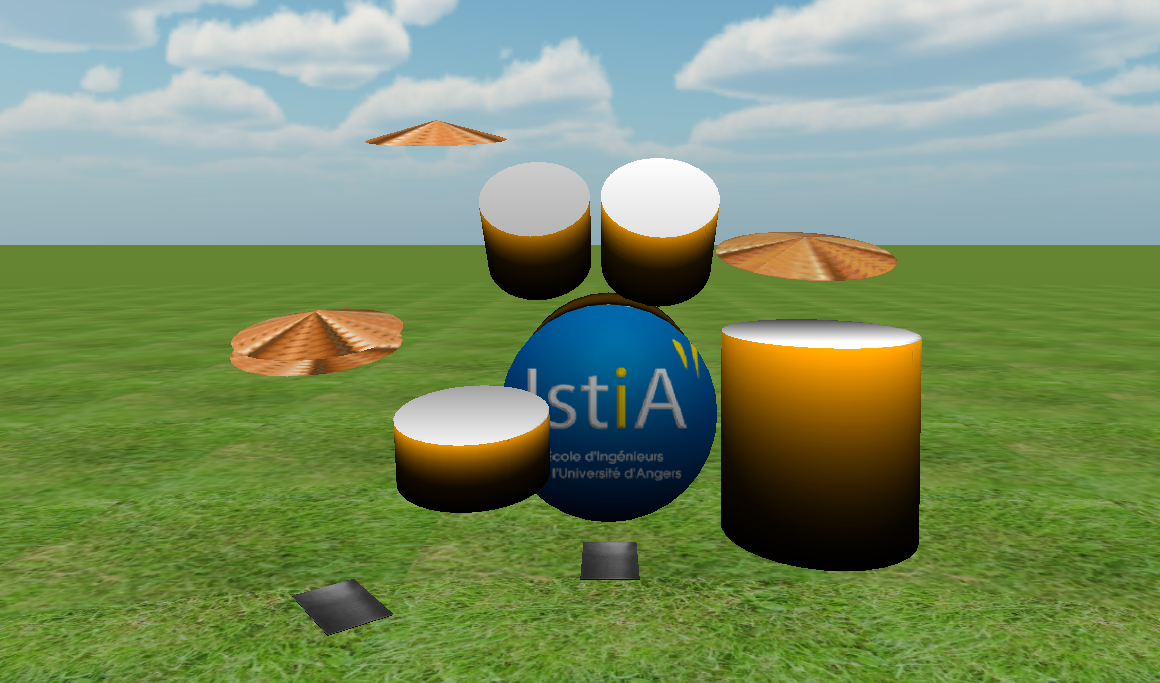

Le projet :

1/ La conception de la maison

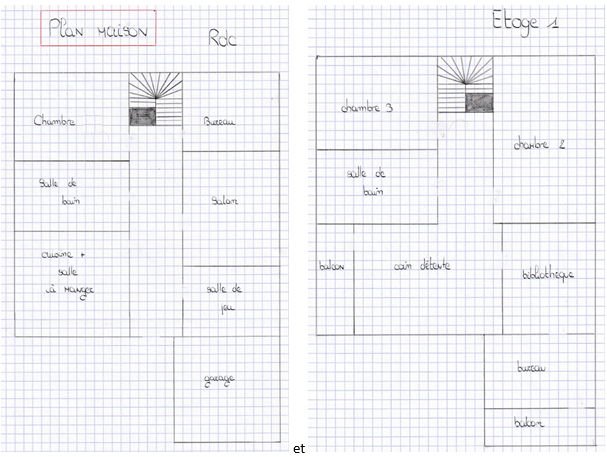

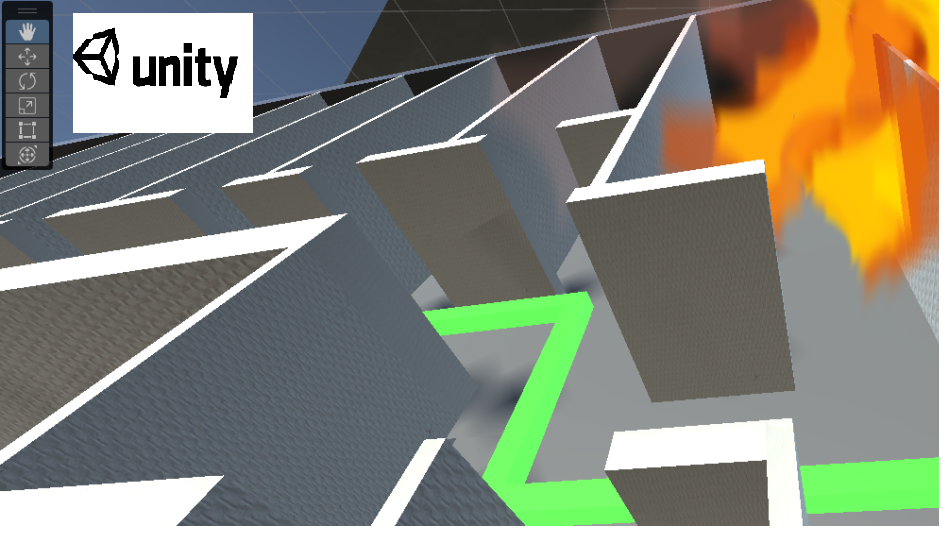

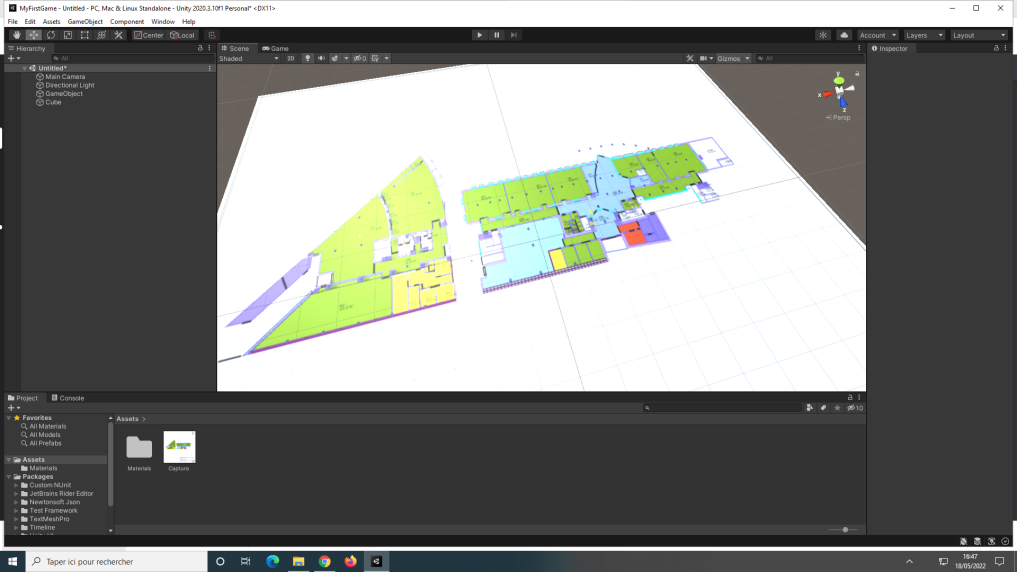

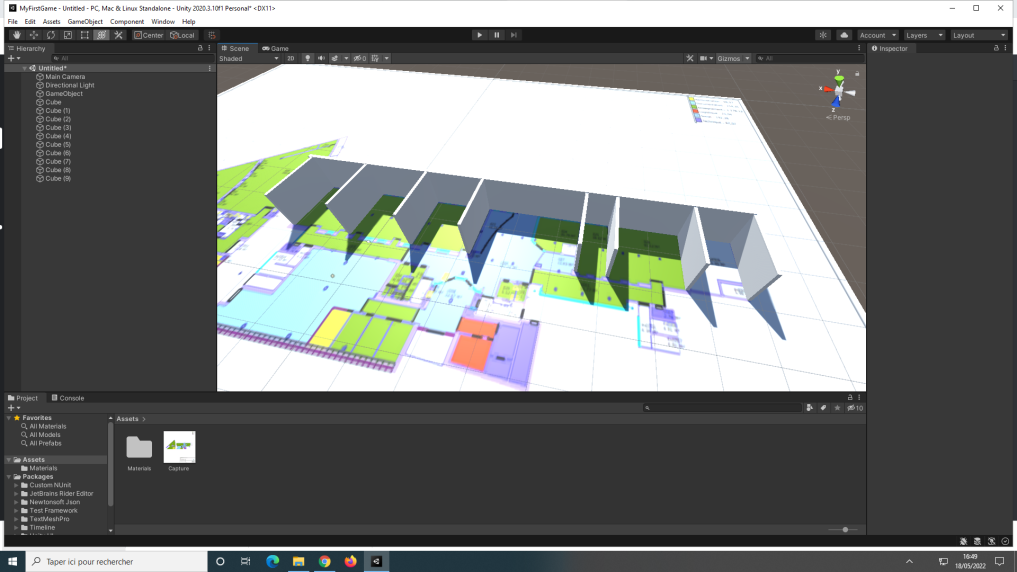

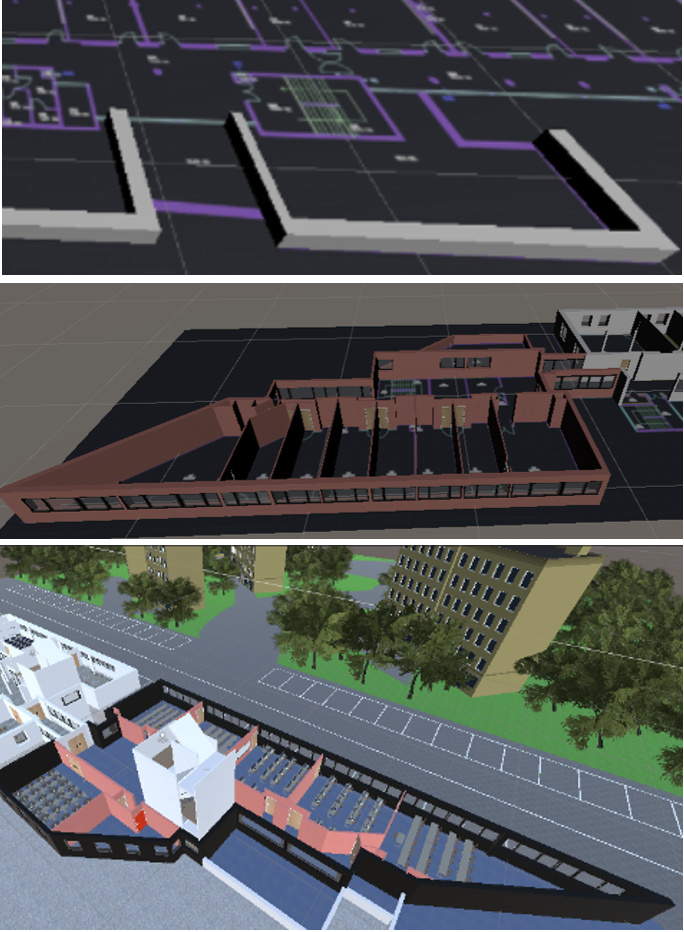

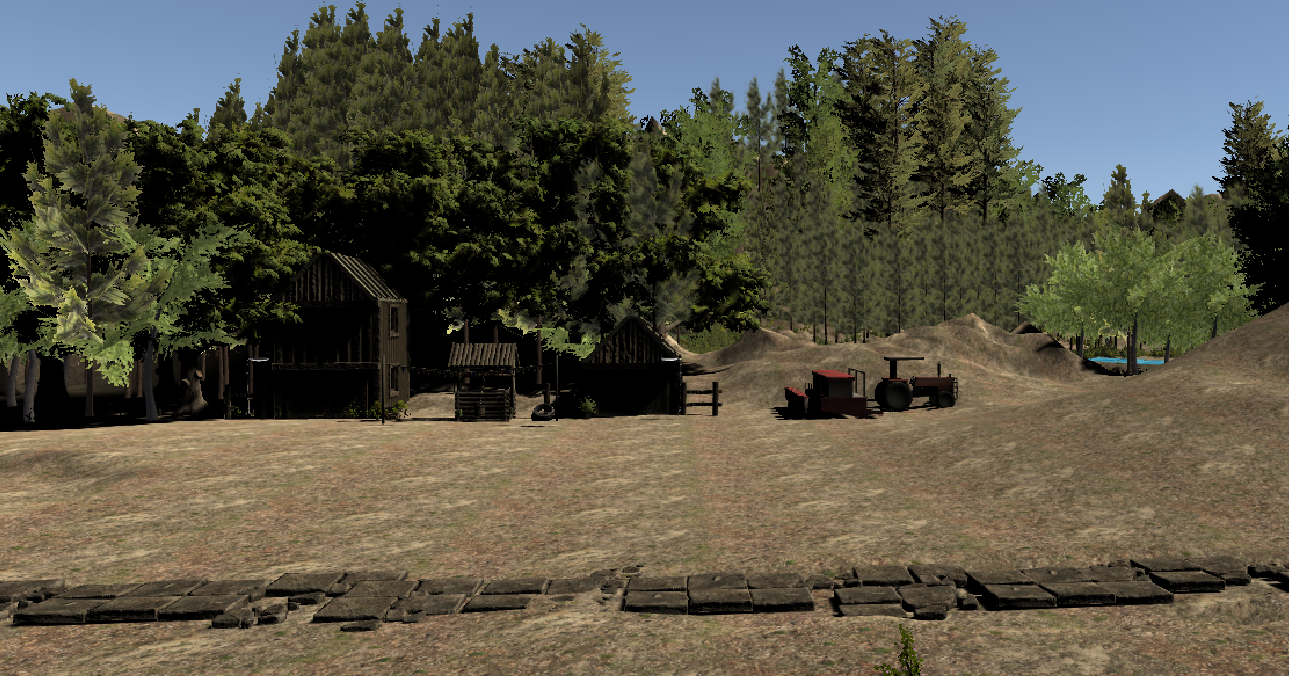

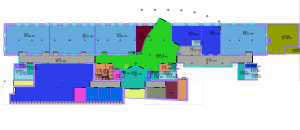

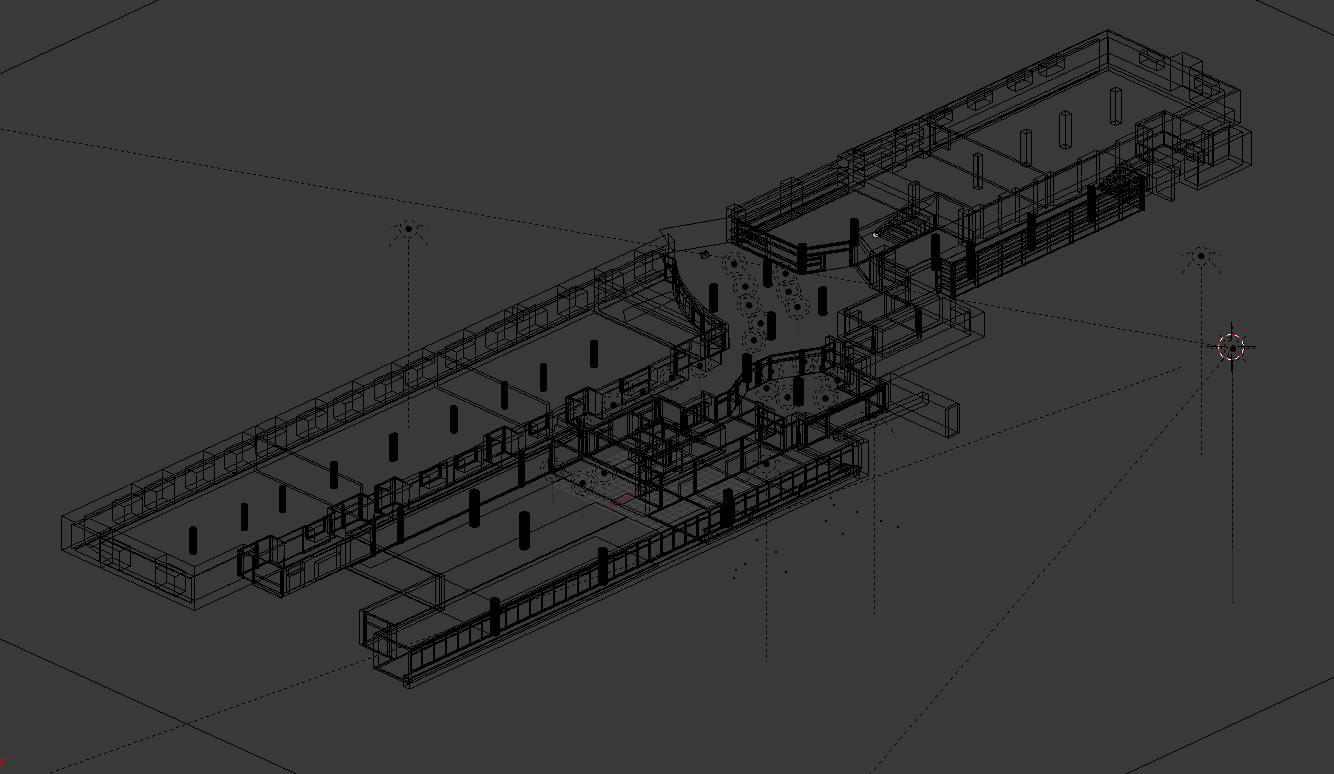

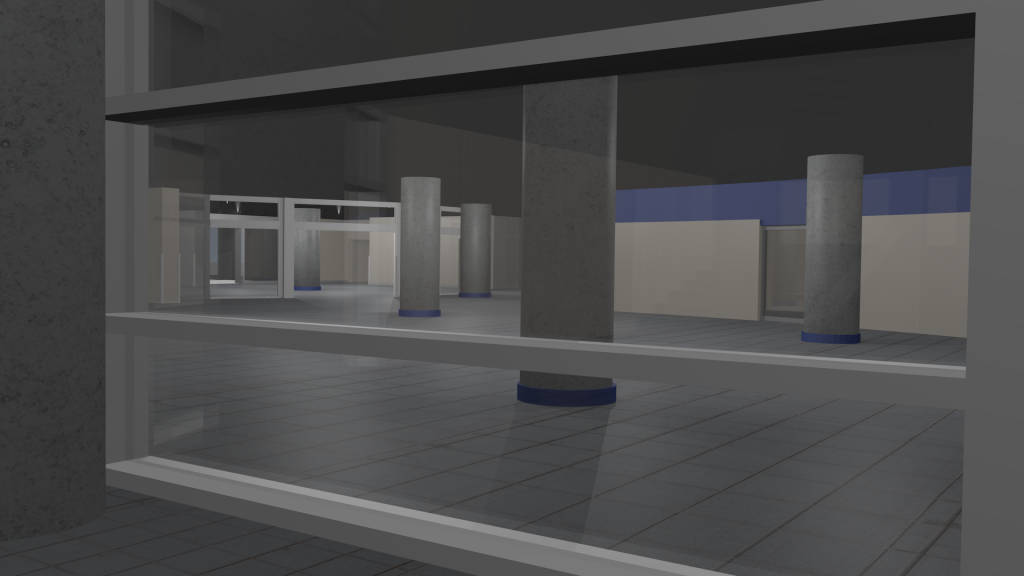

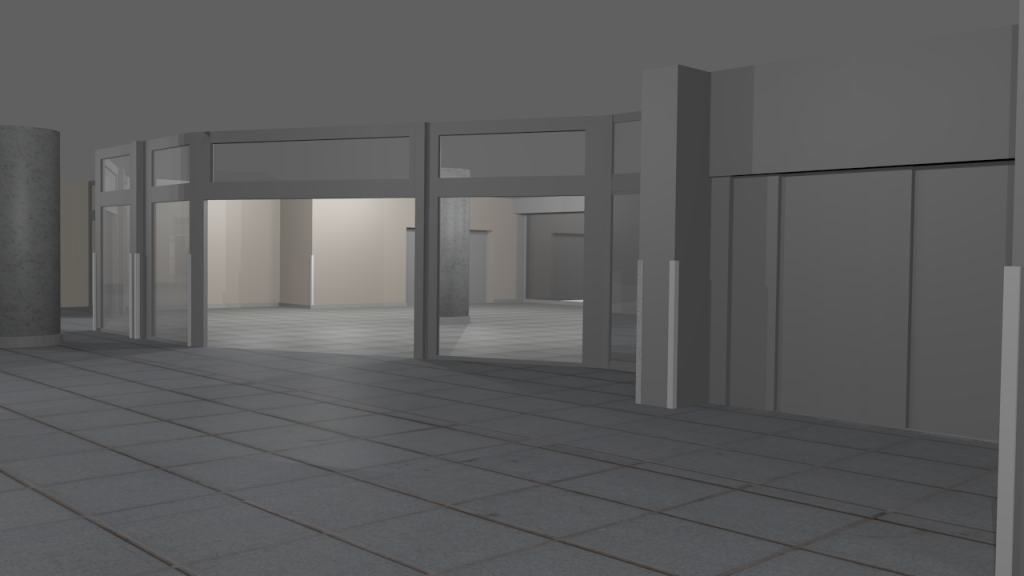

Une des premières réalisations du projet a été l’environnement de l’utilisateur et donc la maison. Le maquettage a permis d’obtenir :

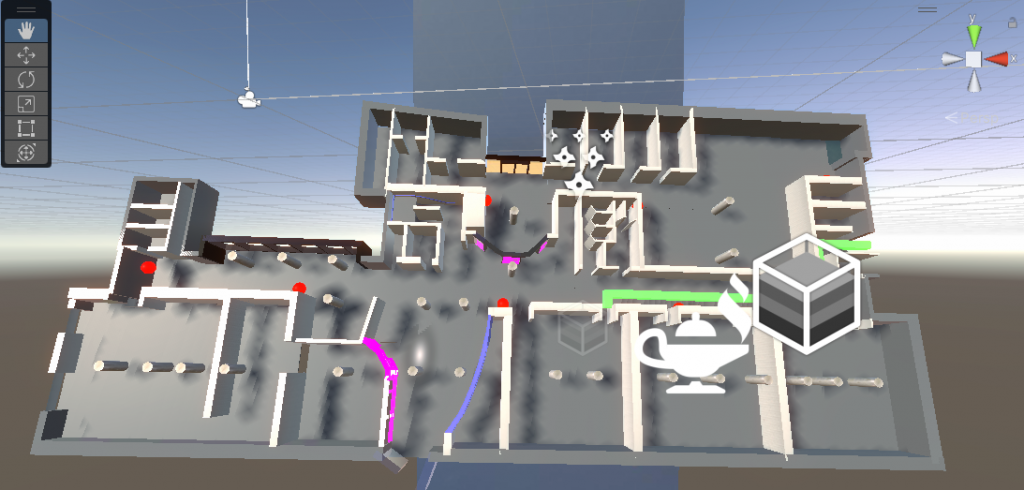

Puis, à l’aide de nos premières compétences Unity et des « Préfabs » à notre disposition, nous avons pu créer et meubler la maison pour obtenir une première modélisation :

Nous avons pensé notre maison afin de refléter la réalité et rendre l’expérience plus immersive. Par la suite, nous avons ajouté nos éléments importants : les équipements interactifs.

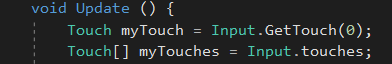

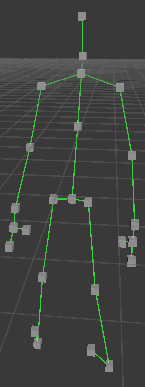

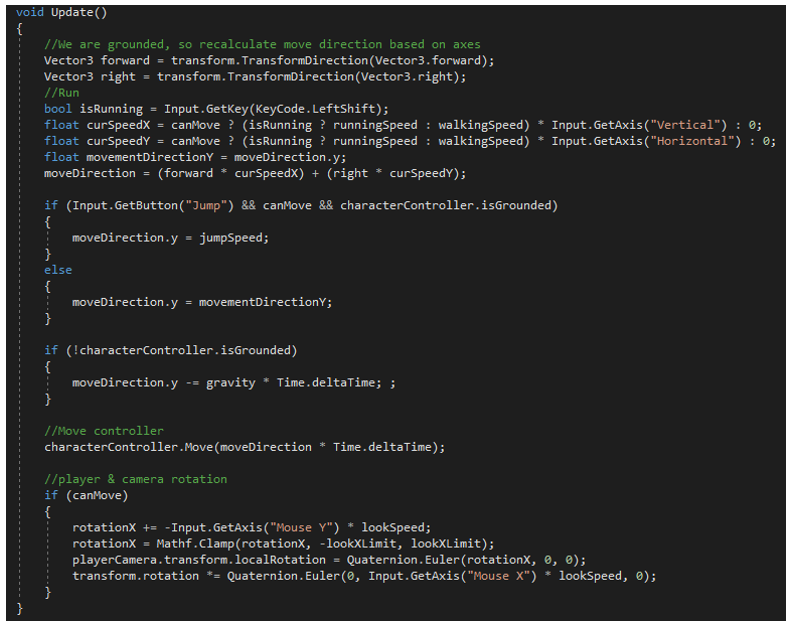

2/ L’utilisateur et ses mouvements : le déplacement et le champ de vision

Les équipements de la maison sont interactifs grâce à des scripts qui permettent à l’utilisateur d’interagir avec eux.

Le premier exemple d’interactivité est la maison elle-même. Cet équipement est interactif puisque l’utilisateur peut s’y déplacer. Le clavier permet les déplacements avant, arrière et latéraux, et la souris permet un mouvement de la tête et donc du champ de vision : vers le haut, le bas, la droite et la gauche.

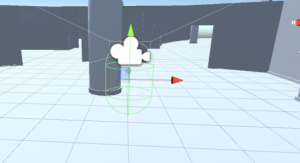

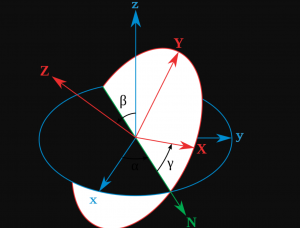

Un second exemple est le champ de vision de l’utilisateur. L’intérêt est de définir ce que « regarde » l’utilisateur afin d’interagir avec l’environnement. Nous avons décidé d’utiliser un raycast. Un raycast est un rayon qui permet de récupérer les informations relatives à chaque objet traversé par celui-ci.

Dans l’exemple ci-contre, le raycast est représenté par le trait rouge (ici émis par la tête de notre utilisateur et représentant ses yeux) pointant dans la direction dans laquelle il regarde.

Ce rayon n’est pas visible par l’utilisateur.

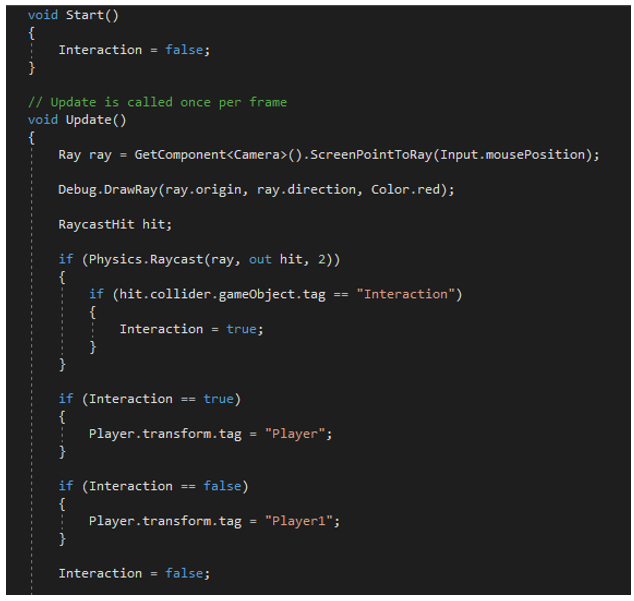

Ainsi, le rayon traverse l’équipement (exemple un interrupteur) seulement si l’utilisateur regarde ce dernier. Une étiquette « Player » est définie pour l’utilisateur et permet d’interagir avec l’équipement uniquement lorsque le raycast rencontre un équipement ayant une étiquette « Interaction ».

Enfin, si l’utilisateur cesse de regarder l’interrupteur, il retrouve alors l’étiquette « Player1 ». Ainsi l’utilisateur peut interagir avec l’interrupteur uniquement s’il est dans la zone définie et qu’il regarde l’interrupteur.

Le code ci-dessous permet de transcrire cela :

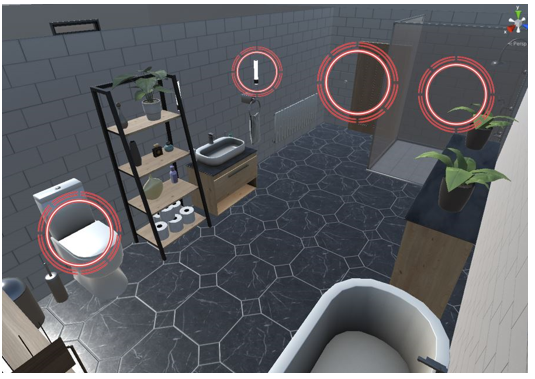

3/ Les équipements interactifs

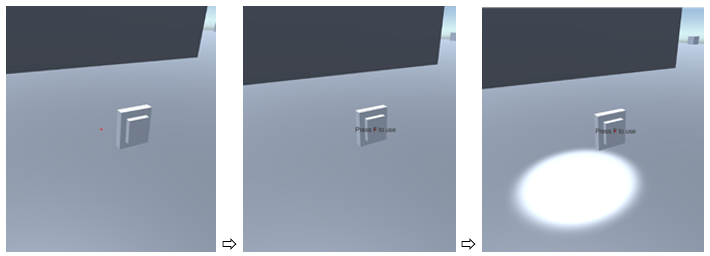

Un exemple d’interaction est la possibilité pour l’utilisateur d’allumer et d’éteindre les lumières. Cela permet de comparer les consommations d’un équipement en marche ou à l’arrêt.

L’image ci-dessous présente les trois états d’un bouton : à l’arrêt, dans le champ de vision de l’utilisateur (avec la possibilité de l’actionner) et le bouton actionné.

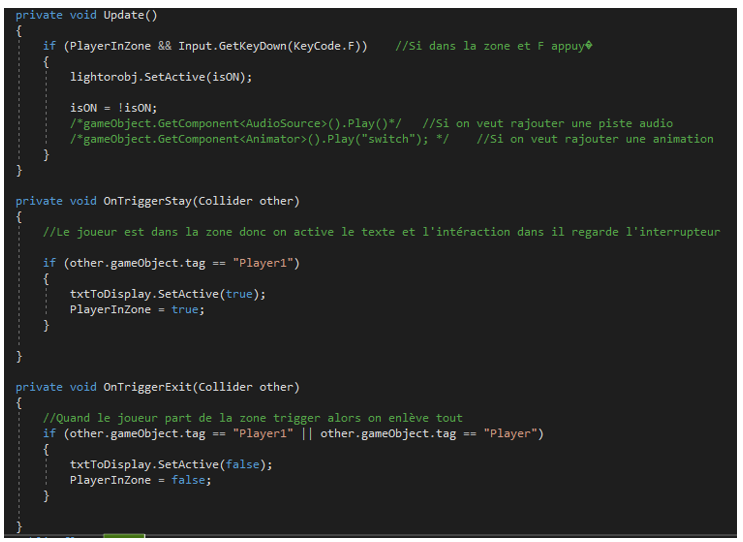

Pour réaliser cette interaction, nous avons écrit le script suivant :

Ainsi, nous avons réalisé des scripts pour : le mouvement des portes, la télévision et les ordinateurs, le lave-linge, les toilettes, la douche, les robinets, la baignoire…

4/ La sensibilisation

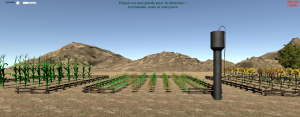

Pour rappel, notre objectif est que l’utilisateur puisse constater la consommation d’un équipement afin d’y être sensibilisé et de modifier son comportement dans le but d’agir pour la planète et aussi peut-être pour ses économies.

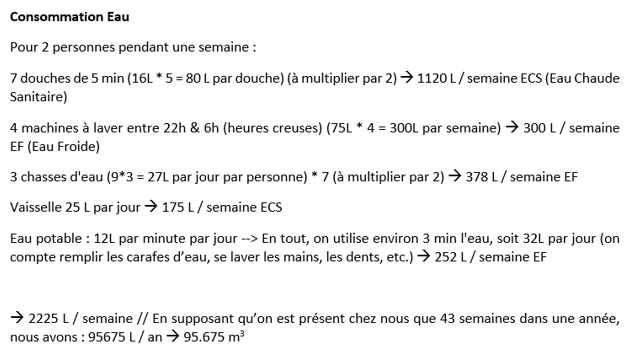

Afin de réaliser cela, nous avons dans un premier temps recensé, pour chacun des équipements, ses consommations d’électricité et/ou d’eau moyennes par jour ou par année. Puis, afin d’améliorer la compréhension de l’utilisateur, nous avons placé ces calculs dans un contexte (celui d’un couple sur une semaine) et proposé un scénario à l’utilisateur :

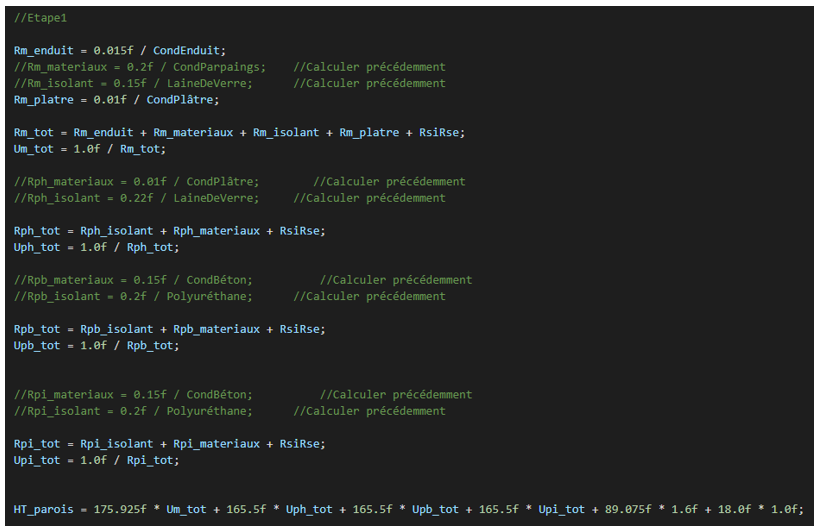

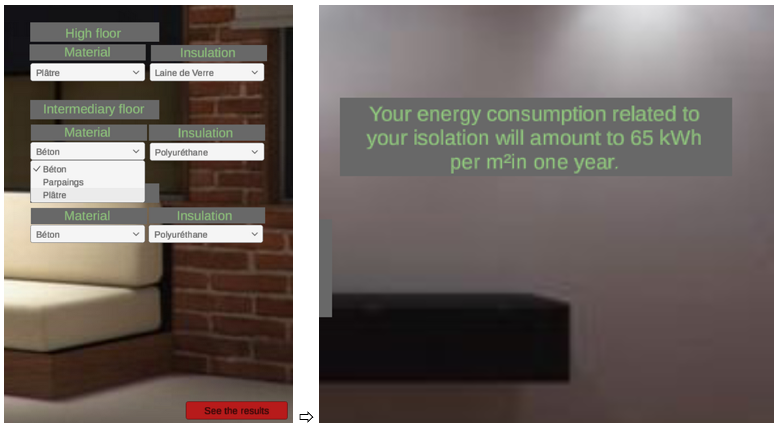

De même, nous avons agrégé les besoins en chauffage en regroupant les déperditions de chaque paroi et les apports de chaleur, tout en prenant en compte le rendement du système de chauffage. Nous avons par la suite codé afin de retranscrire ces données.

Enfin, nous avons ajouté une interface afin de modifier et visualiser ces données et calculs.

Conclusion :

Ce projet répond aux attentes mais est bien sûr perfectible. Nous aurions aimé implémenter un mode réalité virtuelle afin d’améliorer le côté ludique de notre projet. De même, nous pensons qu’il serait intéressant d’intégrer un fichier météo, et de permettre le choix d’une température de consigne dans le bâtiment. Cela améliorerait la qualité des scénarii. Enfin, un code couleur de consommation pourrait faire ressortir les équipements gourmands.

Virtual House, un projet réalisé par Mathys Chien Chow Chine, Antonin Geille, Léo Moncoiffet et Mathis Nagmar, Peip2

Lien du compte rendu : https://files.u-angers.fr/data/f-e20a3117fec1991c.pdf

Lien d’une vidéo de présentation : https://youtu.be/vXtRVafyJbQ