Introduction :

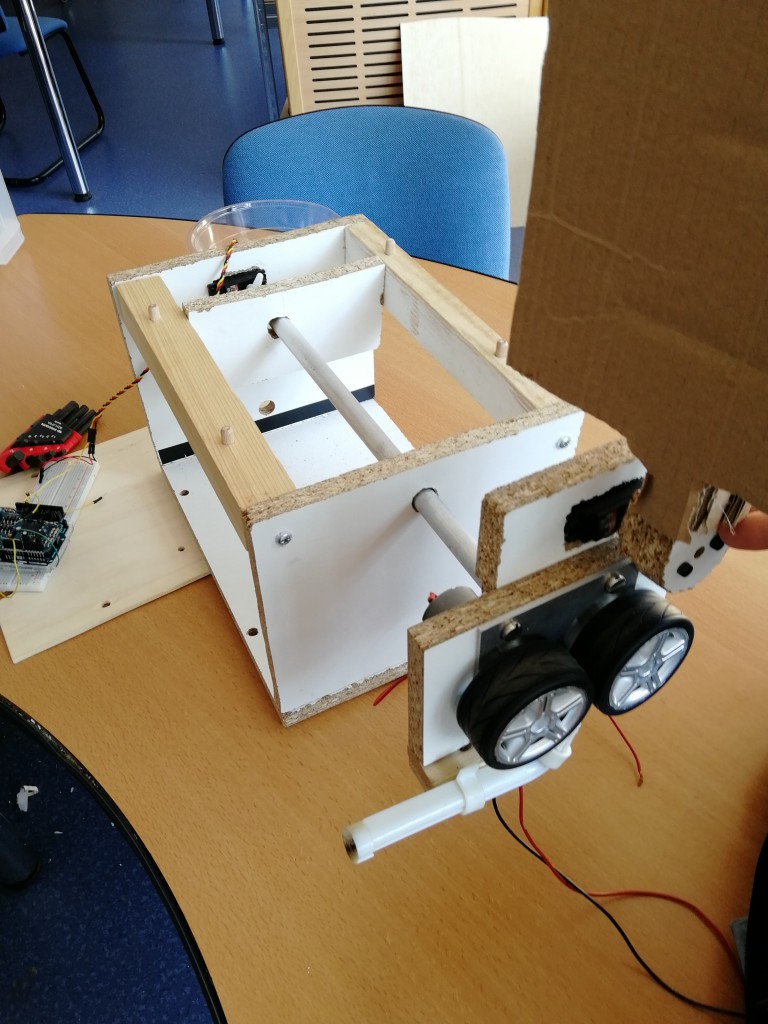

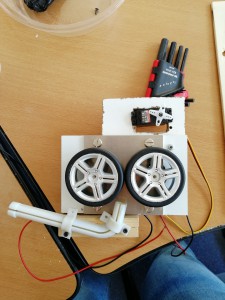

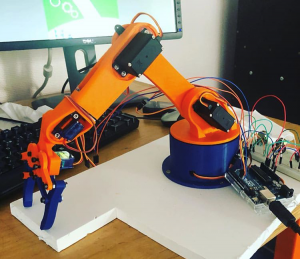

Bonjour, nous sommes Antoine Stourbe et Franck Gluszek, étudiants en deuxième année préparatoire intégrée de Polytech Angers. Dans le cadre de notre projet de conception nous avons décidé d’améliorer un robot photomètre afin qu’il puisse se déplacer et se localiser précisément en milieu extérieur, notamment un stade où son usage pourrait témoigner un intérêt réel dans le milieu des médias.

Intérêt du projet :

Beaucoup pourraient se demander à quoi pourrait servir un robot ayant pour but de mesurer la lumière de manière autonome. Ce qu’il faut savoir c’est que de nombreuses normes d’éclairages sont définies dans le monde du bâtiment et aujourd’hui il est bien plus simple de sur-éclairer plutôt que de prendre manuellement chaque mesures. C’est notamment le cas pour ne nombreux stades où il est nécessaire d’avoir une bonne couverture lumineuse afin de garantir une retransmission agréable aux téléspectateurs .

Les tests :

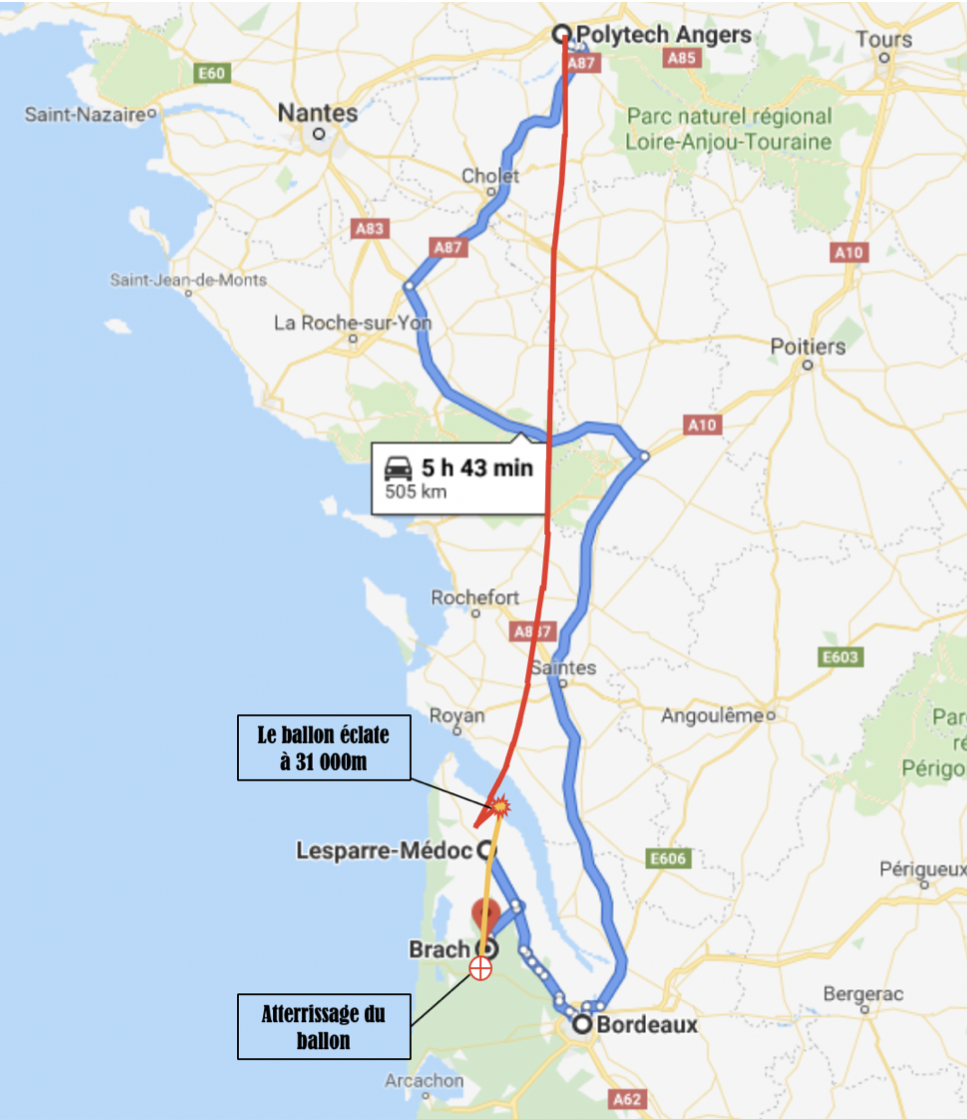

Afin de vérifier si le gps pourrait être installé sur le robot il faut savoir s’il est suffisamment précis et nous permettra de sortir une position du robot permettant en premier lieux de le déplacer en autonomie et puis de sortir une carte des mesures fiables. C’est là que moi et mon collègue intervenons, notre rôle se constituait de tester le gps pour savoir si oui il ferait l’affaire. Et pour cela nous avons effectué trois tests.

Le premier avait pour but de vérifier si le matériel fonctionnait bien. Pour cela nous avons simplement fait le tour de notre école pour savoir s’il pouvait situer notre position de manière correcte. Le résultat ayant été très concluant nous avons décidé de pousser les expérimentations.

Le premier tests :

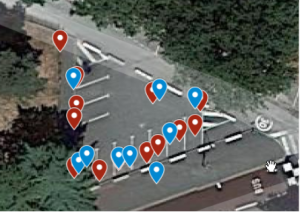

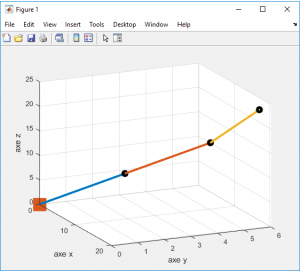

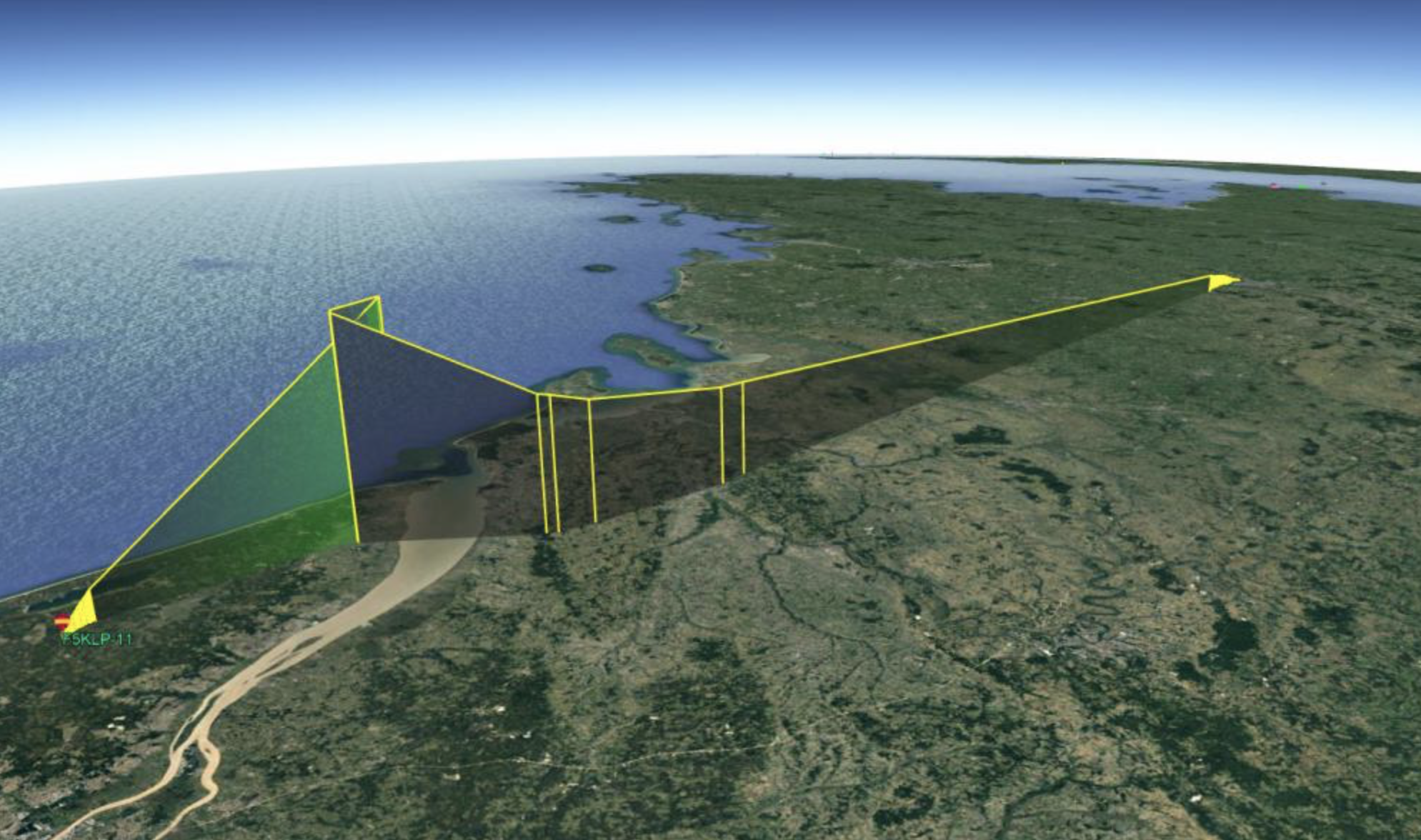

Le second test a été réalisé afin d’avoir une idée de la précision du gps. Pour cela nous nous sommes servis d’un parking afin d’avoir une référence précise entre une position x et celle donnée par le gps x’. Dans ce test nous avons fait 2 tours afin d’augmenter les données récoltées. Et malgré certaines mesures vraiment défaillantes le gps à su précisément retranscrire notre parcour. Seulement les points parasites étaient suffisants à eux-même pour dire que le gps n’était pas fiable. Nous avons donc émis l’hypothèse qu’en marquant une pause à chaques “étapes” nous pourrions éliminer ces coordonnées parasites.

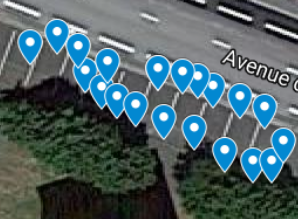

C’est ici que notre troisième test rentre en jeux. Lui aussi avait été fait sur un parking et consistait en deux parcours, l’un des deux serait fait en mouvement constant et l’autre se verrait marqué de pauses de 10 secondes à l’aller puis de 5 au retour afin de voir si ce temps permettrait au gps de mieux se calibrer sur notre position.

Ici nous avons constaté que les données du second parcours étaient bien plus proches de notre trajet que le parcours initial. Seulement les coordonnées n’étaient clairement pas assez précise pour situer notre robot dans ne serait-ce que 250cm².

Problématiques rencontrées :

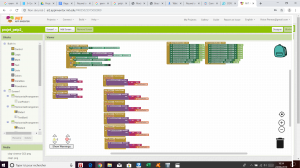

La principale problématique à laquelle nous avons dû faire face est celle de la programmation. En effet malgré les cours fournis durant notre année scolaire nous nous sommes sentis démunis face à cet aspect très présent de notre projet, cela est principalement dû à notre manque d’expérience certain. Malgré cela nous avons réussi à dépasser nos lacunes et mettre en places des programmes réalisés par nos soins, notamment un programme récupérant les trames données par le gps et les stockant dans un fichier texte afin de pouvoir avoir une trace constante des données récupérées.

Le second problème auquelle nous avons fait face fut celui de prendre en compte tout ce qui pouvait fausser les données récupérées par le gps. En effet les données fournies par le gps peuvent être faussées en fonction des conditions météorologiques, de dégagement nuageux, de la présence de corps métalliques ou imposants tel que des bâtiments. Tout autant de choses qu’il faut aussi prendre en compte dans un cas de situation réel, la taille des tribunes d’un stade pouvant par exemple grandement fausser les données reçues par le robot et par conséquent celles qu’il renvoies.

Conclusion :

Lors de ce projet nous avons pu apprendre en quoi consistent les tests permettant de vérifier si oui ou non un composant peut remplir une fonction donnée. Que cela demande une certaine rigueur et que par dessus tout il ne faut s’attendre à rien, juste se fier aux résultats. La plus grande difficulté à laquelle nous avons dû faire face est notre lacune en programmation, mais cette dernière nous à forcer à nous dépasser. Nous aurions apprécié pouvoir effectuer des tests sur le robot mais cela aurait été dans le cas ou les tests précédents se trouvaient être concluants.

Pour finir nous pouvons affirmer que le gps ne conviendrait pas à l’élaboration de ce robot et qu’il faudrait trouver une solution alternative à ce dernier.

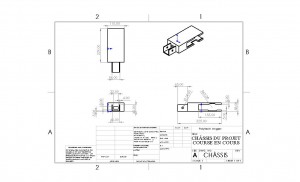

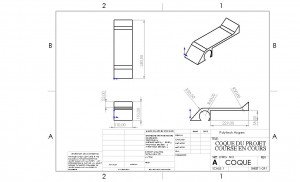

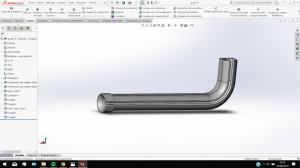

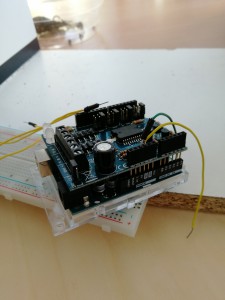

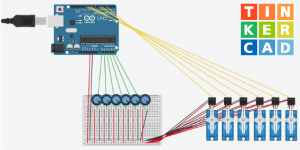

Le matériel à disposition :

En vous remerciant pour votre attention !

Antoine Stourbe

Franck Gluszek